加速替代CUDA!摩爾執行緒開源vLLM-MUSA 加速國產GPU AI

2024-11-07 01:39:51 5

快科技11月5日訊息,近日,摩爾執行緒上線了大語言模型高速推理框架開源專案vLLM的MUSA移植版本,為開發者提供基於摩爾執行緒全功能GPU進行開源專案MUSA移植的範例。

摩爾執行緒表示,正努力圍繞自主研發的統一系統架構GPU、MUSA軟體平臺,構建完善好用的MUSA應用生態。

vLLM是一個高效且易用的大模型推理和服務框架,支援創新的PagedAttention記憶體管理、連續批處理請求、CUDA/HIP圖的快速模型執行、CUDA核心最佳化、分散式推理支援等,可顯著提高大語言模型(LLM)的推理效能。

目前,vLLM已在各種大語言模型中得到廣泛應用,成為業界常用的開源大模型推理框架。

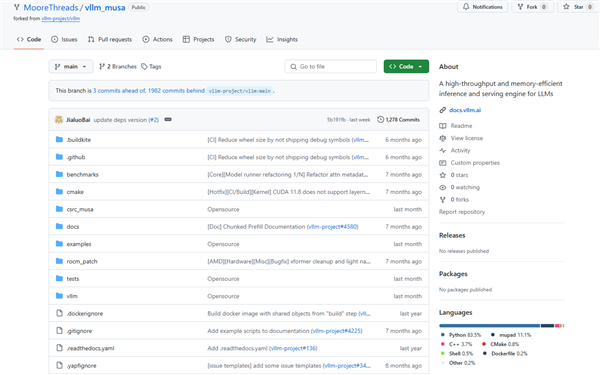

摩爾執行緒基於vLLM v0.4.2版本,進行了移植適配,使之支援摩爾執行緒GPU後端Device,並完全開源,開發者可以二次開發、升級vLLM到社羣更新版本等。

值得一提的是,得益於摩爾執行緒MUSA架構的先進性、軟體棧對CUDA的優良相容性,透過MUSIFY程式碼自動轉換工具,使用者可以快捷地將原有的CUDA程式碼遷移到MUSA平臺,實現替代。

同時,CUDA相關庫的呼叫,也可以快速替換為相應的MUSA加速庫,如運算元庫muDNN、集合通訊庫MCCL、線性代數庫muBLAS等。

摩爾執行緒透過MUSA軟體棧對CUDA軟體棧介面相容,大幅提升了應用移植的效率,縮短了開發週期,還提供MUSIFY自動程式碼移植工具等一系列實用工具和指令碼。

摩爾執行緒vLLM-MUSA開源地址:

https://github.com/MooreThreads/vLLM_musa

本站內容由互聯網用戶自發貢獻,該文觀點僅代表作者本人。本站僅提供信息存儲空間服務,不擁有所有權,不承擔相關法律責任。如發現本站有涉嫌抄襲侵權/違法違規的內容,請發送郵件至舉報,壹經查實,本站將立刻刪除。