美國FDA:警惕AI大模型帶來的未知問題,亟需監管創新

2024-10-18 01:35:17 3

“我經常思考和討論強大 AI 的風險......”

日前,Anthropic CEO Dario Amodei 在其個人部落格中呼籲人們重視人工智慧(AI)安全問題,“原則上 AI 可以幫助好人,也可以幫助壞人”,過於低估 AI 風險將成為“阻礙我們走向積極未來的唯一障礙”。

事實上,在 AI 大模型技術快速發展、深度賦能各行各業的當下,一系列複雜且不可忽視的安全風險也隨之而來。三點陣圖靈獎得主 Geoffrey Hinton、Yoshua Bengio 和姚期智以及幾十位 AI 領域頂尖學者就曾在“AI 安全國際對話威尼斯共識”公開信中警告道,“‘災難性的結果’隨時可能發生。”

而醫療保健作為與所有人息息相關的領域,確保其中 AI 應用的安全,避免“災難性結果”、甚至“一些小錯誤”都顯得更為關鍵。

作為全球領先的醫療監管機構,美國食品藥品監督管理局(FDA)對 AI 新技術和產品的態度對全球醫療行業都有深遠的影響。

日前,FDA 的 Haider J. Warraich、Troy Tazbaz 和 Robert M. Califf 在 JAMA(國際四大醫學期刊之一)上系統性回顧了 FDA 對 AI 的監管歷史,指出 AI 在醫療產品開發、臨床研究和臨床護理中的幾種潛在用途,並提出了在監管系統適應 AI 獨特挑戰時值得考慮的概念。

尤其是,他們在文章中寫道,生成式 AI 的應用,如大語言模型(LLMs),是一個獨特的挑戰,因為它有可能產生不可預見的突發後果,亟需在這一領域進行監管創新,開發者、臨床醫生、衛生系統領導者和監管者之間的合作也至關重要。

FDA 如何監管 AI 醫療產品?

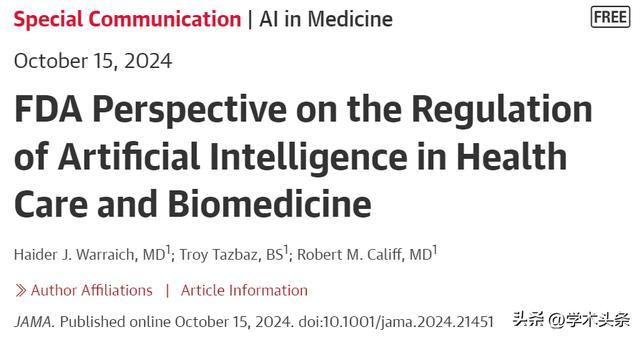

多年來,FDA 在應對 AI 技術發展方面一直扮演著至關重要的角色。作為首個批准部分 AI 驅動的醫療裝置的監管機構,FDA 的歷史可追溯至 1995 年,當時批准了 PAPNET 軟體,旨在透過神經網路來防止宮頸癌誤診。雖然這一技術最初被認為比人類病理學家更準確,但由於成本效益不足,未能廣泛應用。

自那時以來,FDA 已經批准了大約 1000 種 AI 驅動的醫療裝置,尤其是在放射學和心臟病學領域。

圖|FDA 授權銷售的 AI 醫療器械(按年份)(來源:該論文)

最近,FDA 的醫療產品中心描述了關於在醫療產品中開發和使用 AI 的 4 個重點領域:(1)促進合作以保障公眾健康;(2)促進協調標準、指南、最佳實踐和工具的制定;(3)推進支援創新的監管方法的開發;(4)支援與 AI 效能評估和監測相關的研究。

FDA 的監管框架建立在以風險為基礎的策略之上,根據應用的風險程度,在 AI 方面,可分為非監管、部分監管和高度監管的醫療裝置。FDA 注重採取靈活的監管措施,例如透過生命週期管理方法,持續監控 AI 驅動裝置的安全性和有效性。

圖 | AI 的整個產品生命週期方法(來源:該論文)

同時,FDA 也展示了對創新技術的開放態度,推出了例如“軟體預認證試點計劃”等專案,為新興技術的發展鋪平道路。

此外,FDA 與全球的監管機構保持合作,以推動 AI 最佳實踐的全球協調,尤其是在醫療裝置領域。

AI 在醫療保健領域的應用

事實上,AI 為醫療產品開發的多個方面提供資訊的潛力是深遠的,並且已經開展了較為豐富的應用。而對於 FDA 而言,想要對此開展良好監督與評估的前提是充分了解該技術應用。

目前,AI 在醫療保健領域的應用主要集中於藥物開發與臨床研究兩方面。

在藥物開發方面,AI 正在徹底改變開發的各個階段。當前,AI 已被廣泛應用於藥物發現的早期階段,例如透過機器學習模型分析大規模基因組資料、預測藥物與靶標的相互作用,從而加速潛在候選藥物的篩選與最佳化。

此外,AI 在藥物設計中也發揮著重要作用,特別是在透過計算預測化合物結構和藥物活性之間的關係上,AI 大幅縮短了藥物開發的時間。AI 還可以透過分析時間序列資料以補充藥代動力學和藥效學模型。

未來,AI 在藥物開發中的潛在用途還包括最佳化流程設計並實施高階流程控制、智慧監控以及維護和趨勢監控,還能夠透過分析個體遺傳資料,設計出針對特定患者的定製化治療方案。

在臨床研究方面,AI 正在迅速成為臨床研究中的關鍵推動力。當前,AI 主要用於提高臨床試驗的效率和精度。例如,AI 可以透過大資料分析和自然語言處理(NLP)從臨床試驗資料庫、試驗公告、社交媒體、醫學文獻、登記庫以及登記處和電子健康記錄中的結構化和非結構化資料中挖掘資料,將個人與試驗相匹配,從而篩選合適的試驗參與者,解決傳統臨床試驗中受試者招募慢、代表性不足等問題。

此外,AI 還能在臨床試驗資料收集、管理和分析以及上市後安全監測和評估等方面做出卓越貢獻。

AI 監管亟待創新

然而,隨著 AI 技術在醫療領域的廣泛應用,FDA 面臨著新的挑戰,包括 AI 模型不斷進化和技術應用複雜性的增加使得監管難度直線上升。這要求未來的監管工作不僅需要確保技術的安全性和有效性,還需透過跨學科的合作與創新,積極應對 AI 技術帶來的潛在風險。

FDA 已經意識到傳統的靜態監管方法不再適用 AI 的快速演進,特別是對於生成式 AI 和大語言模型等新興技術,這些技術具有不可預見的潛在後果。

例如,生成式 AI 在診斷、治療等領域雖能帶來巨大創新,但也存在潛在的錯誤和偏見風險,如 AI 醫療記錄助手可能會錯誤生成未經討論的診斷。因此,需要為這些複雜 AI 模型開發專門的工具,評估其輸出的可靠性和安全性。現有的一些評估工具如 DeepEval 已經顯示出一定的效果,但更深入的監管創新仍是必要的。

此外,文章指出,AI 模型的後續監測與持續評估是保障其安全性的關鍵,AI 技術的表現受環境變化的影響較大,需要在其使用的臨床環境中進行持續的實時監控。未被監控的 AI 系統可能在實際操作中產生重大危害,這一領域也急需新的管理工具和方法來應對。

因此,在監管 AI 技術時,將更加註重長期的效果監測,並強調合作和透明度,以確保 AI 在醫療領域的創新安全和有效。

三位作者在文末寫道:所有相關部門都需要以謹慎和嚴謹的態度對待人工智慧這項可能帶來變革的技術。

本站內容由互聯網用戶自發貢獻,該文觀點僅代表作者本人。本站僅提供信息存儲空間服務,不擁有所有權,不承擔相關法律責任。如發現本站有涉嫌抄襲侵權/違法違規的內容,請發送郵件至舉報,壹經查實,本站將立刻刪除。