OpenAI回應一切,o1、GPT年前都會升級!奧特曼:別嫌慢,問就是缺算力

2024-11-02 01:35:09 2

關於OpenAI的一切訊息,官方這次全回應了!!

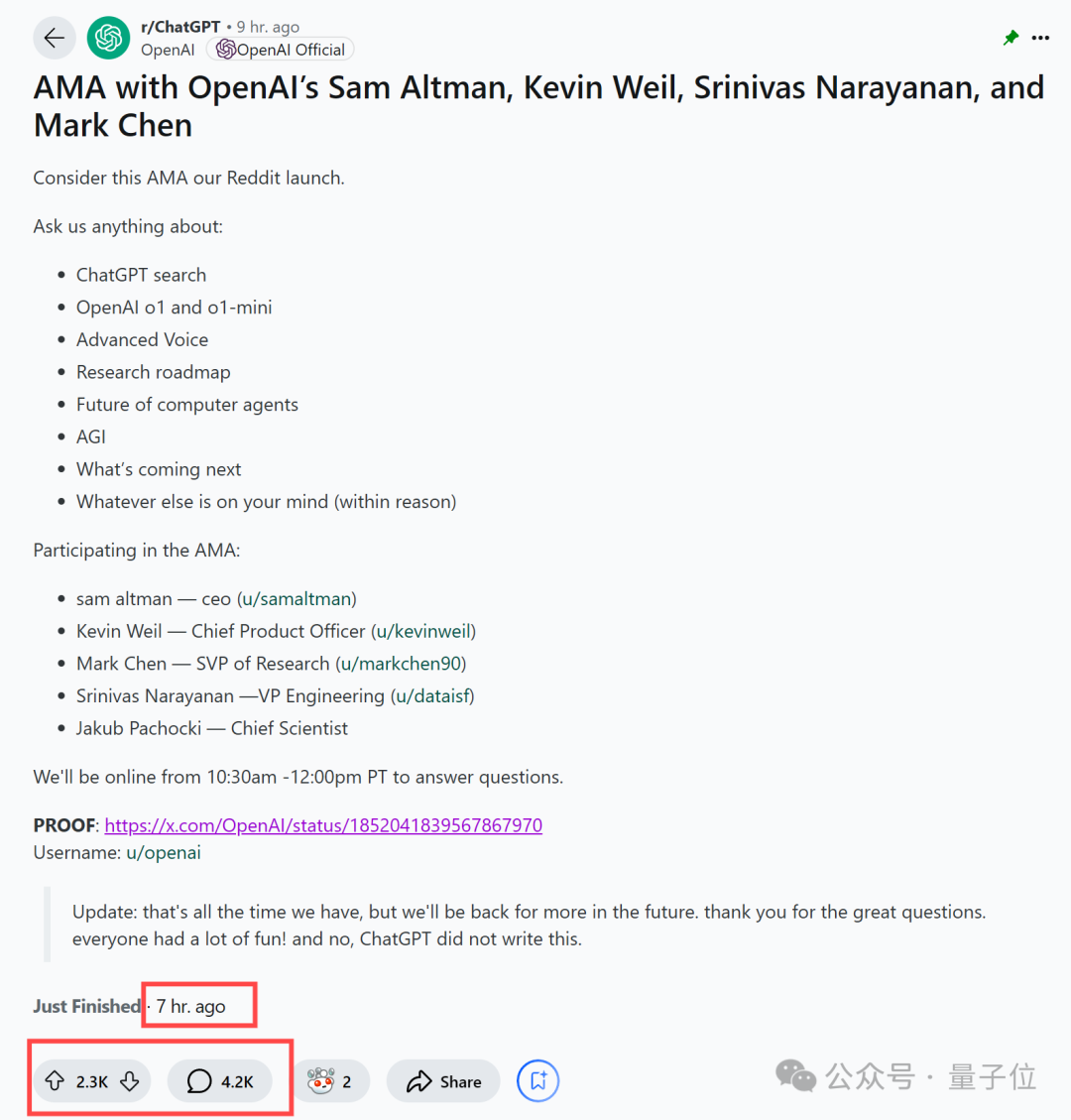

就在剛剛,CEO奧特曼攜4大高管集體亮相reddit有問必答活動(AMA ),挨個回覆了大家對OpenAI主要產品、AGI路線規劃等提問。

具體陣容包括,首席產品官Kevin Weil、高階研究副總裁Mark Chen、工程副總裁Srinivas Narayanan和首席科學家Jakub Pachocki。

如此豪華陣容也當即引來大量關注,僅過去幾小時,reddit已有4000多條網友留言。

先來個省流版,在這次活動上,OpenAI團隊主要透露了:

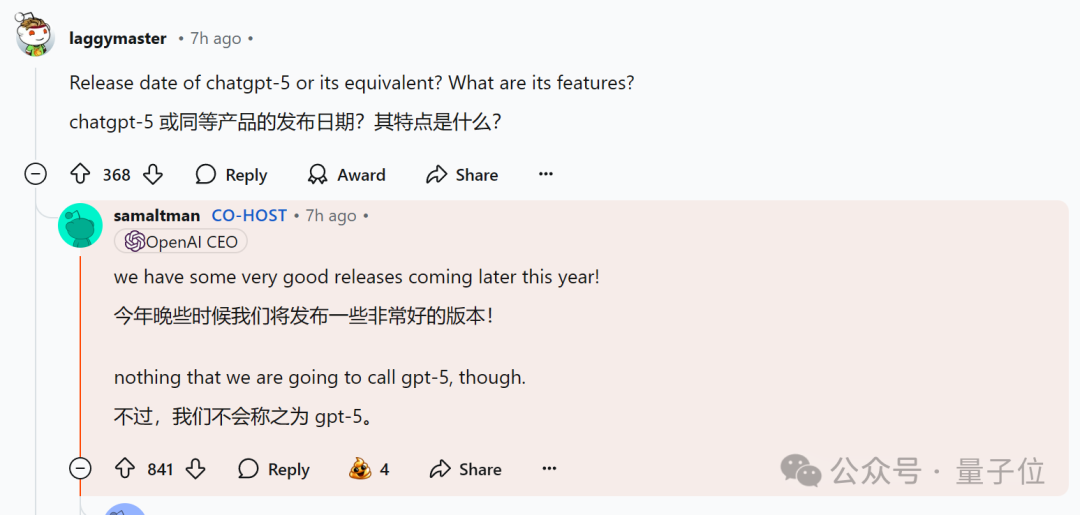

年底將會有重大更新,但不會命名為GPT-5

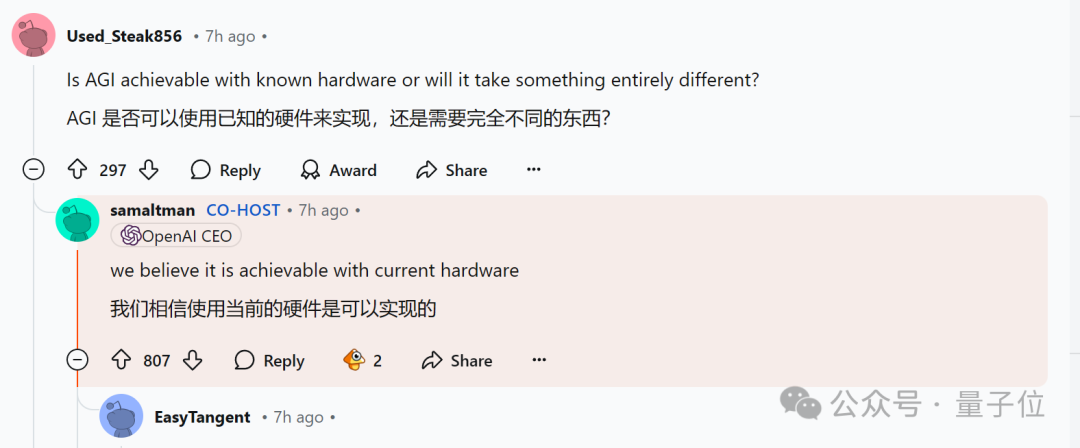

當前的硬體可以實現AGI

缺少計算資源是阻礙產品推遲的主要因素

影象生成模型DALL-E的下次更新值得期待,但目前無釋出計劃

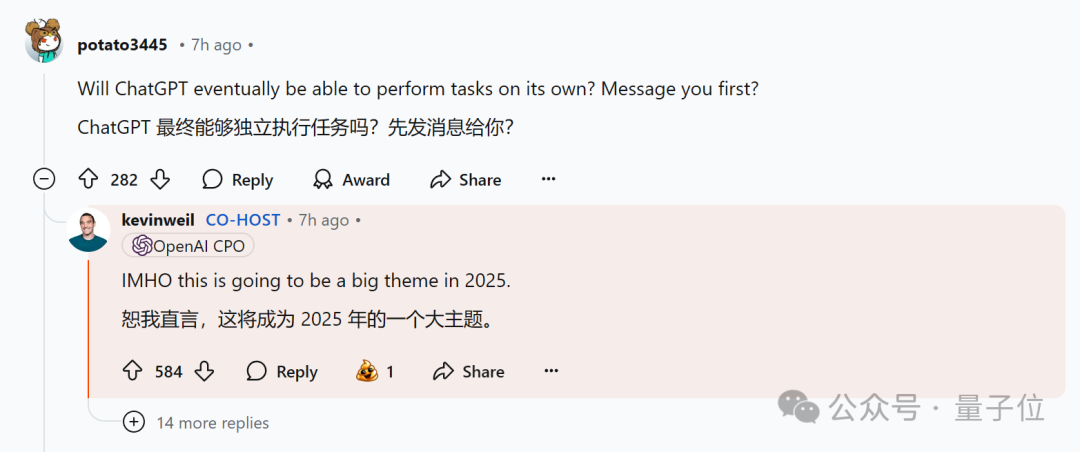

讓ChatGPT自主執行任務將是明年一大重點

Sora還需要完善,暫無明確釋出時間表

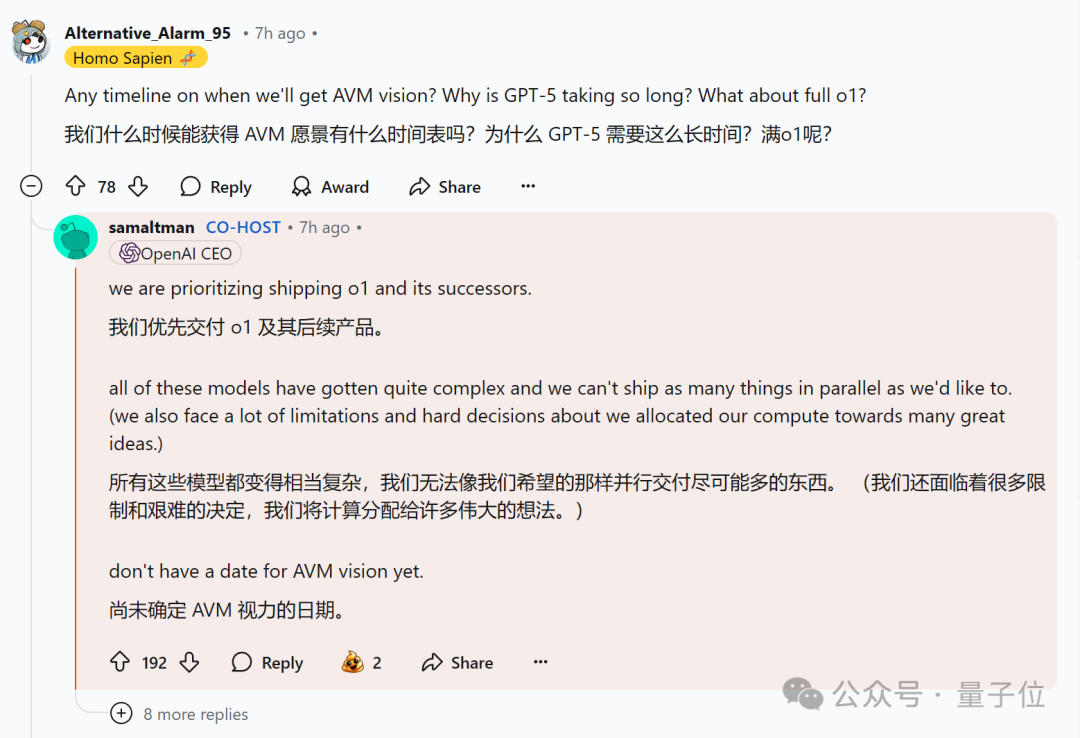

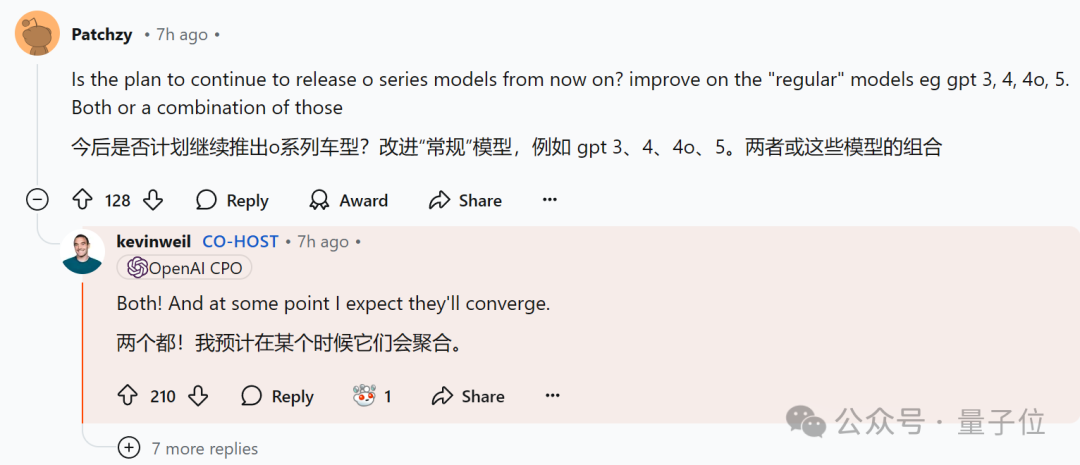

o1系列和GPT系列將同步推進,未來也可能整合

o1滿血版即將推出

……

好傢伙,這次的資訊密度有億點高,準備好瓜子咱們接著嘮(doge)。

OpenAI回應一切

一上來,網友們就開始了貼臉開大,紛紛喊話對面的OpenAI團隊:

你還記得大明湖畔的Sora、GPT-4o視訊通話、DALL-A……嗎?

對此,CEO奧特曼開始訴苦(bushi,承認缺少計算能力是阻礙公司更快交付產品的主要因素。

最近還有報道稱,奧特曼和OpenAI首席財務官對員工抱怨,微軟行動速度不夠快,沒有提供足夠的伺服器。

兩家的聯盟關係也正在逐漸破裂,並開始互相視對方為備胎——

OpenAI找了甲骨文做額外的雲端計算供應商,微軟也開始在自家產品中接入谷歌和Anthropic模型。

除此之外,為了減少對英偉達的晶片依賴,OpenAI近幾個月還在與博通合作開發AI晶片,不過預計最早要等到2026年才能上市。

多方跡象顯示,OpenAI目前確實在計算能力上面臨壓力。

不過拋開這點不談,奧特曼此次自信宣稱,人類當前的硬體已經可以實現AGI了。

與此同時,更多重點產品訊息釋出:

首先,奧特曼照例放出重磅煙霧彈,暗示年底可能會發布重要產品,只不過不會將其命名為GPT-5。

他表示,一方面模型變得越來越複雜了,另一方面有限的算力還需要分配給“許多偉大的想法”。(傳聞OpenAI擅長在內部同時推進很多專案)

而對於當前存在的GPT和o1系列模型,OpenAI目前會同步開發、釋出,不過將來也不排除整合的可能性。

同時,o1滿血版將很快推出。

另外,對於大家一直關注的影片生成模型Sora,目前還是沒有明確的釋出時間表。

官方說法是,Sora還需要進一步完善,需要考慮安全方面的因素。(Sora負責人前一陣還跳槽谷歌了)

同樣的,對於期待值頗高的GPT-4o的視訊通話功能,以及久未更新的影象生成模型DALL-E系列,OpenAI仍然態度曖昧模糊,能夠看出,他們的重點目前不在這些上面。

所以,OpenAI最近的重點是啥呢?

最新答案來了:AI搜尋。

就在今天,撐ChatGPT新增了搜尋功能,背後由GPT-4o的微調版本提供支,而且網頁版、手機版、桌面版同時上線。

據介紹,其最主要的亮點是“快速獲取準確答案,並提供相關網頁連結”,無需再切換至其它的搜尋引擎。

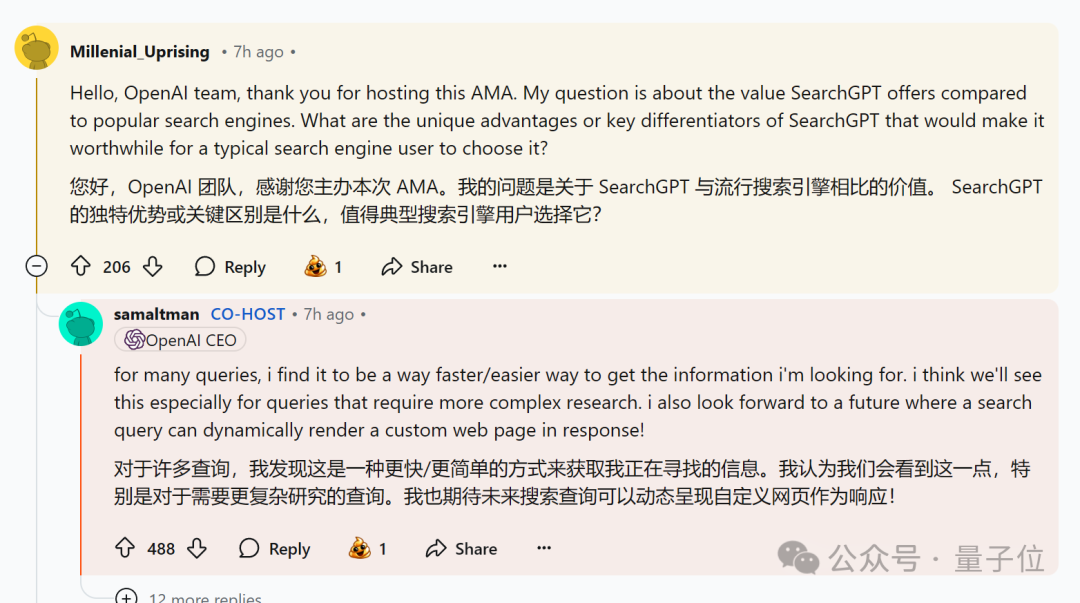

有網友藉機提問奧特曼,ChatGPT search優勢何在?我們為什麼要放棄傳統搜尋引擎?

對此,奧特曼認為AI搜尋主要應用於更復雜的場景,最好能動態呈現自定義網頁作為響應。

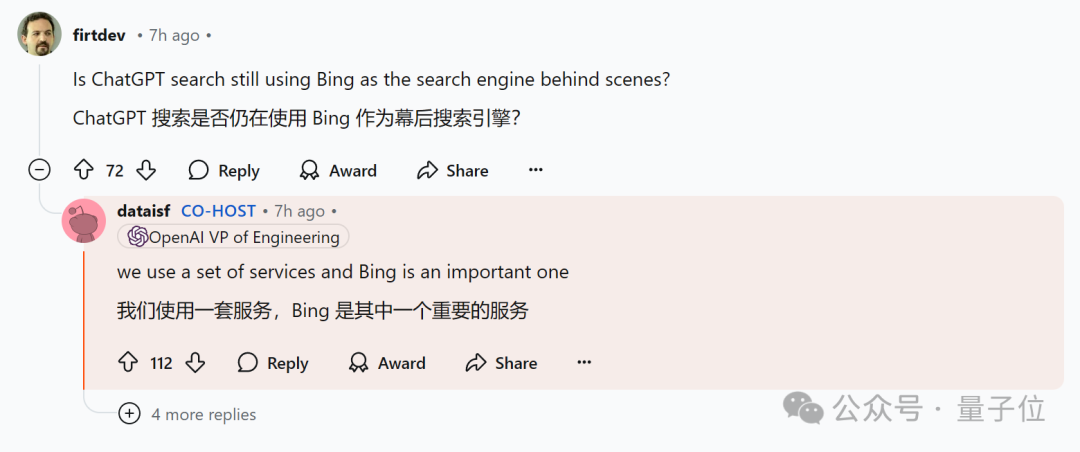

而且OpenAI透露,ChatGPT搜尋仍然使用了微軟的Bing。

最後,OpenAI明年的重點之一是——讓ChatGPT自主執行任務。

要知道,隔壁家的Claude目前已經能接管我們的電腦了,僅需輸入指令,Claude就能幫我們完成訂比薩、做攻略等任務。(OpenAI要加油了)

網友們還關注這些

除了上面這些大眾關切,部分網友也原地開啟了許願模式。

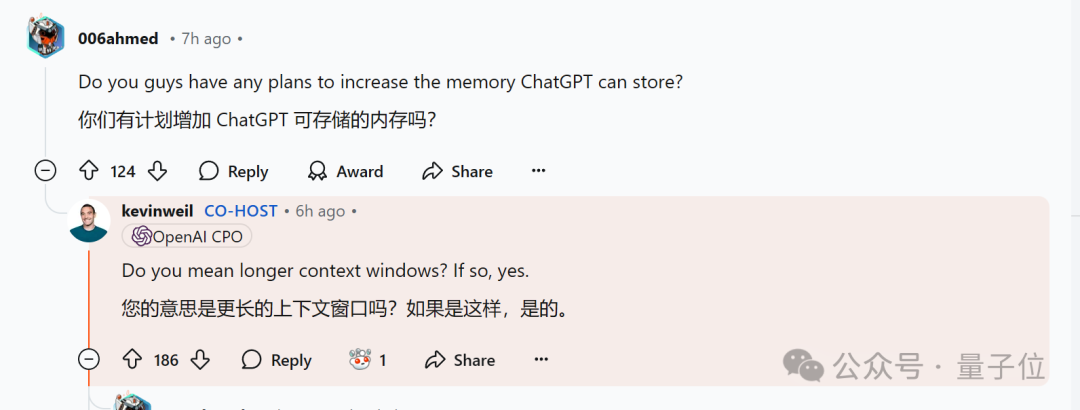

Q:GPT-4o的文字能否擴充套件?32k不太夠用。

A:在努力了!

而且不止GPT-4o,OpenAI可能會為ChatGPT增加上下文視窗。

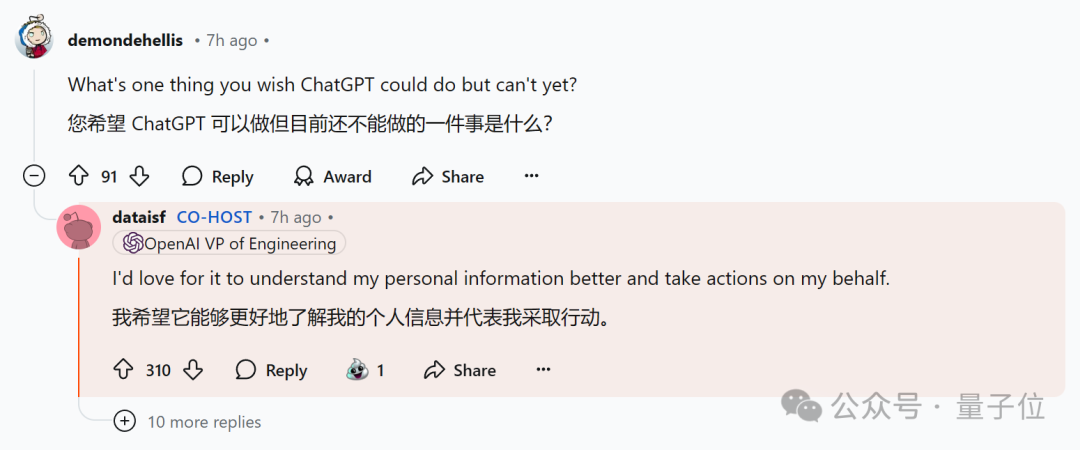

Q:ChatGPT可以做但目前還不能做的一件事是什麼?

A:代替人類,自主理解並執行任務。

Q:ChatGPT的最佳用例以及未來在哪些領域會特別有用?

A:發現並治療疾病,以及加速新的科學發現。

Q:是否有計劃釋出一項新功能,讓使用者能看到自己在ChatGPT被引用的方式和頻率?

A:會考慮這個好主意,目前沒有計劃。

Q:AGI是否可以透過已知的神經網路架構實現,或者是否需要新的科學(基礎)突破?

A:如果架構突破是由現有的LLM提出的,這算不算?(暗示新架構也可能由LLM提出)

Q:高階語音的API成本會降低嗎?

A:語音和其他功能都考慮進一步降低成本。(GPT-4o mini的成本目前是GPT-3的2%)

Q:模型幻覺會成為永久性特徵嗎?如何應對?

A:很難避免,OpenAI正在使用的解決方案包括:加強出處引用、使用強化學習(模型不產生幻覺時,實行獎勵)。

Q:對明年的大膽預測?

A:使所有基準測試達到飽和。(自信起來)

最後,有人突發奇想,提問奧特曼是否會使用ChatGPT來回答上述問題。

結果沒想到,還真有。(就emmm……)

Ilya看到了什麼?

有意思的是,一聽到OpenAI團隊要來個“知無不言”,大家夥兒不約而同地又問出了那句:

what did Ilya see?

懟到眼前來了,CEO奧特曼自知躲不過,於是乖巧回覆道:

他是一位令人難以置信的有遠見的人,他的一些最初想法最終成就了o1模型。

嗯,感覺每次回答都一樣,大家可以放棄這個問題了(doge)。

問不出來,真的問不出來……

參考連結:

[1]https://www.reddit.com/r/ChatGPT/comments/1ggixzy/ama_with_openais_sam_altman_kevin_weil_srinivas/

[2]https://x.com/OpenAI/status/1852041839567867970

[3]https://news.ycombinator.com/item?id=42010712

— 完 —

本站內容由互聯網用戶自發貢獻,該文觀點僅代表作者本人。本站僅提供信息存儲空間服務,不擁有所有權,不承擔相關法律責任。如發現本站有涉嫌抄襲侵權/違法違規的內容,請發送郵件至舉報,壹經查實,本站將立刻刪除。